컴퓨터 비전은 인간의 시각을 컴퓨터가 가질 수 있도록 하는 컴퓨터 과학과 인공지능(AI)의 한 분야입니다. 1960년대부터 오랜 시간 연구되어 온 긴 역사와 방대한 응용 분야를 고려하면 상용화에 가까워졌다고도 할 수 있습니다. 스마트폰의 카메라를 이용한 신용카드 스캔 등의 기술이 익숙한 예입니다. 컴퓨터 비전은 인공지능(AI)과 증강현실(AR) 등의 기술이 발전하면서, 응용 분야가 본격적으로 확장되고 있습니다. 지난 11월에 출시된 애플의 아이폰X가 좋은 사례입니다.

아이폰X에는 얼굴을 인식하는 기능인 ‘페이스 ID(Face ID)’가 탑재되었습니다. 아이폰X 전면의 트루뎁스(TrueDepth) 카메라가 얼굴에 적외선을 투사하여 얼굴 데이터를 수집하고, 인공신경망 프로세서인 뉴럴 엔진(Neural Engine)으로 얼굴 데이터를 학습하여 잠금을 해제하는 기술입니다.

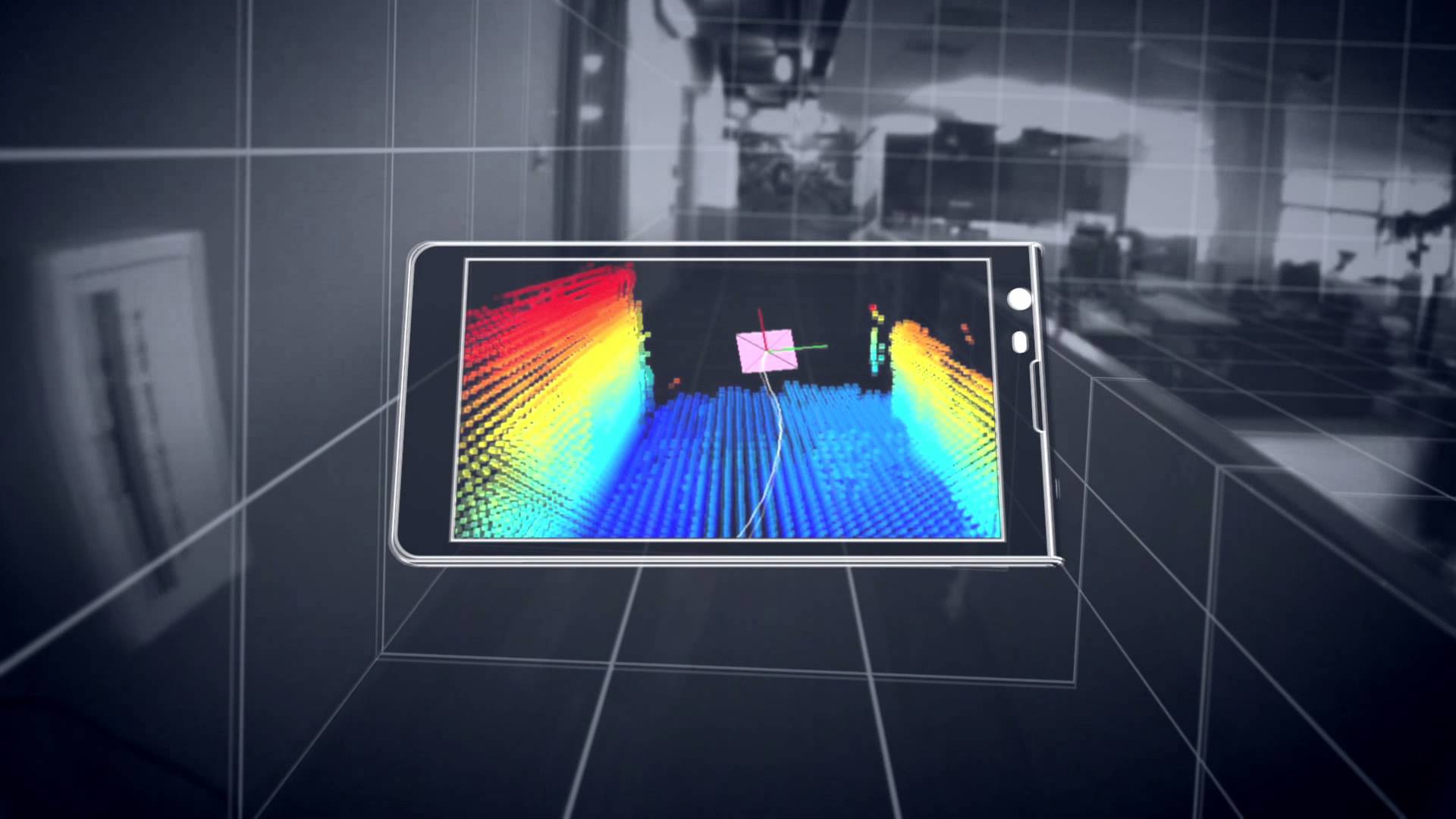

트루뎁스 카메라의 심도 인식은 활용에 따라 얼굴뿐만 아니라 사람의 움직임이나 사물도 인식할 수 있습니다. 현재 뉴럴 엔진은 페이스 ID를 위한 프로세서지만, 앞으로 개발자들이 머신러닝을 효율적으로 구현하는 데에 도움이 될 것입니다. 뜬소문으로는 차기 아이폰의 후면에 트루뎁스 카메라를 포함한 3D 카메라를 탑재할 것으로 알려졌습니다.

뜬소문이 신빙성 있는 건, 오는 3월에 중단 예정인 구글의 AR 플랫폼인 ‘탱고(Tango)’도 좀 더 현실적이고, 실용적인 AR 구현을 위해 제휴 제조사들과 함께 3D 카메라를 탑재한 스마트폰을 출시했다는 점입니다. 탱고를 종료한다는 점에서 3D 카메라의 탑재에 실패했다고 생각할 수도 있으나, 구글은 ‘AR 코어(AR Core)’라는 애플의 ‘AR 킷’에 대응하는 새로운 플랫폼을 출시했고, 여러 스마트폰 제조사들이 탱고를 비롯한 3D 카메라의 탑재와 함께 뉴럴 엔진과 같은 인공신경망 프로세서의 탑재를 준비하고 있습니다.

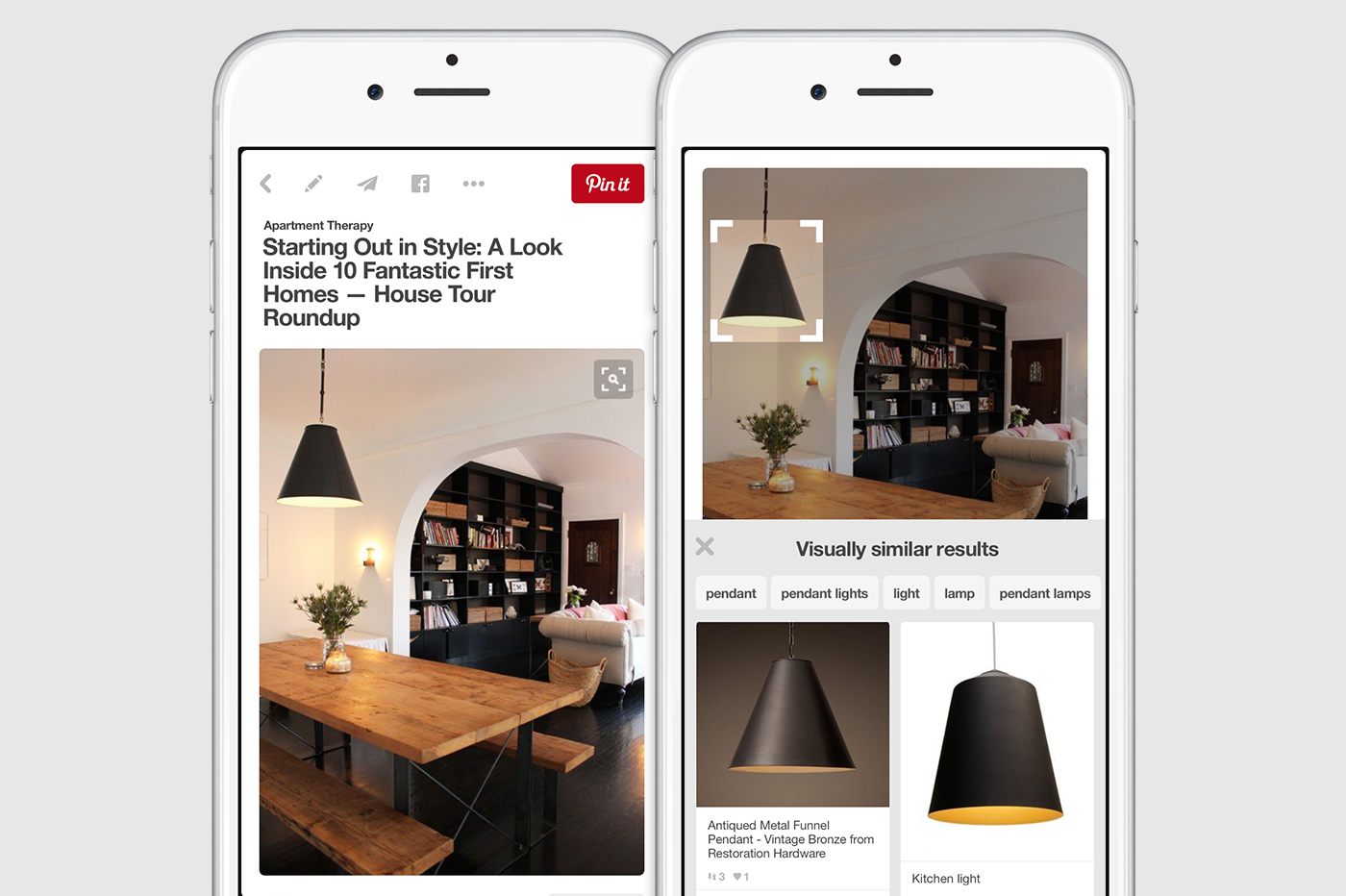

‘이미 AR 킷과 AR 코어를 통해 높은 수준의 AR을 3D 카메라가 없는 스마트폰에서도 구현하고 있지 않은가?’라고 생각할 수도 있습니다. 이에 대해서는 소셜 미디어인 핀터레스트(Pinterest)의 창립자 벤 실버맨(Ben Silbermann)의 발언이 좋은 대답이 될 것 같습니다.

실버맨은 한 인터뷰에서 ‘저는 카메라가 다음 세대의 키보드가 될 것이라고 믿습니다.’라면서 ‘이것은 당신 주위의 세계에 질문을 던지거나 주변을 발견하거나 어떤 것이 삶에 적합한지를 시각화하는 근본적인 도구가 될 것입니다.’라고 말했습니다.

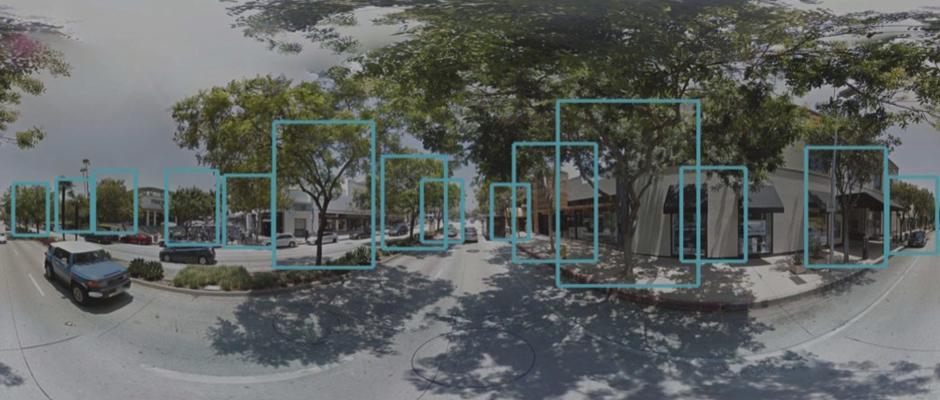

핀터레스트는 대표적인 컴퓨터 비전 기술 업체입니다. 이미지 분석 검색인 ‘시각 검색’을 제공하죠. 공유된 사진에 포함된 개체가 무엇인지, 또는 개체와 비슷한 것들을 찾아줍니다. 예를 들어, 영화배우가 입은 코트가 마음에 든다면, 코트 부분만 검색하여 어떤 코트인지 찾을 수 있고, 사진만 뚜렷하다면 가격부터 판매하는 웹 사이트까지 검색할 수 있습니다.

구글의 이미지 검색과 비슷한 기능으로 여길 수도 있습니다. 확실하게 다른 점은 비슷한 이미지를 찾는 것이 아니라 검색 대상인 이미지의 사물이나 사람, 동물을 분석하여 비슷한 것들을 찾을 수 있도록 한다는 거죠. 지난 20년 동안 온라인에서 겨울 코트를 검색하려면, 검색창에서 겨울 코트라는 검색어를 입력해야 했습니다. 그러고는 원하는 디자인과 색상의 코트를 찾기 위해서 스크롤을 꾸준히 내려야 했죠.

겨울 코트라는 검색어가 검색하는 사람의 취향까지 포함하고 있지는 않으니 말입니다. 하지만, 핀터레스트는 사물을 인지하는 컴퓨터 비전 기술을 통해서 이용자들이 원하는 것을 쉽게 검색하도록 합니다. 카메라가 다음 세대의 키보드가 될 것이라는 말에 수긍할 수 있는 부분이죠.

그렇다면, 실버맨의 발언과 핀터레스트가 선보인 컴퓨터 비전 기술은 AR과 어떤 연관이 있을까요? 분명 AR 킷과 AR 코어로 스마트폰을 이용한 높은 품질의 AR이 구현이 수월해진 건 맞습니다. 그러나 실질적인 활용으로 확장하는 데에 한계가 있습니다.

AR 마케팅을 예로 들어봅시다. AR 킷과 AR 코어의 등장으로 자동차나 가구 업체들은 소비자들이 자사 제품들을 AR을 통해 실물 크기로 확인할 수 있는 앱들을 출시했습니다. 가상으로나마 제품의 실제 모습을 볼 수 있으니 사진보다는 나은 셈이죠. 단지 소비자들을 해당 마케팅에 참여토록 하려면 AR에 접근하게 할 제품이나 브랜드에 대한 충분한 정보가 필요합니다. 정보가 부족하다면 AR에 접근하지 못할 가능성이 크므로 마케팅 효율은 떨어지죠.

이런 부분을 시각 검색으로 보완할 수 있습니다. 가령 지나가던 중 주차된 마음에 드는 자동차를 발견했고, 어떤 모델인지 온라인에서 찾으려면 현재는 자동차에 박힌 제조사의 로고와 크기를 토대로 검색어를 구성하여 검색해야 합니다.

시각 검색을 이용하면 자동차를 카메라로 비추는 것만으로 어떤 모델인지 찾을 수 있을 뿐만 아니라 검색 결과와 연결된 AR 앱을 통해 실물 크기의 가상 모델을 보여주거나 해당 모델의 다른 색상을 마스크로 덮어씌울 수 있겠죠. 자동차의 입체 구조를 인식하는 능력이 뛰어날수록 가상의 마스크는 실제 자동차와의 뜨는 부분 없이 페인트를 칠한 것처럼 덮어질 수 있을 겁니다.

스마트폰에 눈 역할을 할 고성능 3D 카메라를 통해 사물과 AI가 인지한 주변 환경에 대한 시각 정보에 따라 가상의 개체를 추가할 수 있는 AR 기술의 활용 범위가 훨씬 넓어질 수 있다는 것입니다.

이런 시도를 앞서 실행한 기업도 있는데요. 바로 아마존입니다. 아마존은 2014년에 자체적으로 개발한 스마트폰인 ‘파이어폰(Fire Phone)’을 출시했습니다. 아마존의 대표적인 실패작으로도 꼽히지만, 시대를 앞선 혁신적인 기기이기도 합니다. 파이어폰은 4개의 적외선 카메라를 탑재하여 컴퓨터 비전 알고리즘을 실시간 처리할 수 있도록 했습니다. 마치 아이폰 X의 트루뎁스 카메라가 얼굴을 인식하고, 뉴럴 엔진이 데이터를 처리하는 것처럼 말이죠. 그리고 이 카메라는 파이어플라이(Firefly)라는 검색 기능에 활용되었습니다.

파이어플라이는 컴퓨터 비전을 활용한 검색 기능입니다. 명함에 적힌 전화번호로 전화하고 싶다면 카메라로 스캔하는 것만으로 명함의 전화번호를 인식하여 연결해줍니다. 또는, 마음에 드는 제품을 스캔하면 제품에 대한 설명과 판매처를 알려주고, DVD를 스캔하면 아마존 프라임 비디오에서 해당 영화를 찾아 바로 재생합니다.

파이어플라이로 검색할 수 있는 상품만 7,000만 개가 넘었죠. 아마존은 파이어플라이의 인식 정확도를 높이기 위해 18개 이상의 컴퓨터 비전 기술을 파이어폰에 적용했습니다. 카메라를 검색을 위해 키보드를 대신할 스마트폰의 눈으로 바꿔놓은 겁니다.

(출처 : https://www.amazon.com/Amazon-Fire-Phone-32GB-Unlocked/dp/B00OC0USA6)

하지만 상기한 것처럼 파이어폰은 실패했습니다. 획기적이었지만, 상품을 찾아주는 것만으로 파이어폰을 구매하기에는 다른 매력이 부족한 탓이었습니다. 다만, 파이어폰에 적용한 컴퓨터 비전 기술까지 사라진 것은 아닙니다. 계산대 없는 마트로 불리는 식료품점인 ‘아마존 고(Amazon GO)’에 컴퓨터 비전과 머신러닝, 딥러닝 기술을 결합하여 적용했기 때문입니다.

아마존 고의 이용객은 계산을 위해 줄을 서거나 기다리지 않아도 됩니다. 매장에 설치된 카메라가 매장에 들어선 순간부터 움직임을 추적하고, 장바구니에 담은 상품을 인식한 후 매장을 빠져나가면 스마트폰에 저장한 신용카드로 자동 결제됩니다. 그러나 기술적 결함으로 아마존 직원들을 대상으로 실험 개장한 것에 머물렀습니다. 한 번에 20명 이상의 이용객을 추적할 수 없다는 게 문제였죠. 20명 이하라도 움직임이 빠르면 카메라는 이용객을 놓쳤습니다.

블룸버그에 따르면, 최근 기술적 결함은 거의 해결된 것으로 알려졌으며, 인상착의가 같은 이용객이 다수 있더라도 추적할 수 있을 정도로 발전했다고 아마존 고를 이용한 아마존 직원들은 말했습니다. 블룸버그는 곧 아마존 고가 정식 개장할 것으로 전망했습니다. 파이어플라이에서 시도된 기술이 식료품점을 운영할 수 있는 수준까지 발전한 것입니다.

아마존은 아마존 고가 식료품점인 만큼 컴퓨터 비전과 머신러닝 기술을 식료품의 신선도를 확인하는 데까지 활용할 계획입니다. 이미 아마존 내부적으로는 상한 딸기와 그렇지 않은 딸기를 컴퓨터가 구분하도록 실험한 것으로 알려졌습니다. 보편화한다면 컴퓨터의 눈이 분류한 딸기를 컴퓨터의 눈이 추적하는 매장에서 사 먹을 수 있겠죠.

또한, 아마존도 AR 킷과 AR 코어처럼 AR과 가상현실(VR) 요소를 제작할 수 있는 개발자 도구인 수메리안(Sumerian)을 지난 11월에 출시했습니다. 앞서 아마존은 판매 중인 상품을 실물 크기로 볼 수 있는 AR 앱을 선보이기도 했는데, 수메리안을 통해 여러 사물을 쉽게 AR과 VR로 적용할 수 있게 하겠다는 것입니다.

그리고 뉴욕타임스(NYT)는 아마존 고라는 식료품점을 개장한 것처럼 아마존이 컴퓨터 비전과 머신러닝, 그리고 AR을 접목한 오프라인 가구 매장을 구상 중이라고 보도했습니다. 수메리안을 통해 AR과 VR에서 독자적인 개발자 생태계를 구성할 수 있다면, 컴퓨터 비전과 머신러닝이 결합한, 아마존 고와는 다른 획기적인 오프라인 매장을 기대할 수 있으리라 예상합니다.

이런 성과로 아마존은 AI와 컴퓨터 비전 생태계를 확장하기 위해 기업용 카메라인 ‘딥렌즈(DeepLens)’를 출시했습니다. 딥렌즈는 딥러닝 기술을 포함하고 있습니다. 카메라를 통해 광학 문자와 이미지, 사물을 인식할 수 있습니다. 개체 감지와 인식을 지원하는 인텔 아톰 X5 프로세서와 딥러닝 소프트웨어 도구인 인텔 매스 커널 라이브러리를 활용하여 파이어폰의 실시간 컴퓨터 비전을 작은 카메라 형태로 내놓은 것입니다. 기업은 딥렌즈를 활용함으로써 창고나 매장을 관리할 수 있는 AI 카메라를 쉽게 개발할 수 있게 되었습니다. 마치 아마존 고처럼 말이죠.

이에 컴퓨터 비전을 통한 AI 생태계 선도에 위협을 느꼈는지 구글은 라즈베리파이로 구동하는 컴퓨터 비전 장치를 만들 수 있는 ‘AIY 비전 킷(Vision Kit)’을 12월에 발표했습니다. 구글은 5월에 누구나 AI 기기를 만들 수 있게 하겠다는 목적의 ‘AIY(AI yourself)’ 프로젝트를 발표했고, AIY 비전 킷은 프로젝트의 두 번째 DIY 킷입니다.

(출처 : https://blog.google/topics/machine-learning/introducing-aiy-vision-kit-make-devices-see/)

AIY 비전 킷은 인텔의 이미지 프로세서가 탑재된 보드와 케이블, 카메라 렌즈와 촬영 중임을 표시할 수 있는 LED와 골판지로 만든 케이스가 포함되어 있습니다. 구글의 머신러닝 모델인 텐서플로우(TensorFlow)를 활용하고, 딥렌즈와 마찬가지로 실시간 컴퓨터 비전을 실현할 수 있다는 점이 특징이지만, 가격은 44.99달러로 딥렌즈보다 200달러나 저렴합니다. 전원장치와 SD 카드 등 장치는 별도로 구매해야 하지만, 골판지 케이스와 저렴한 프로세서로 누구나 컴퓨터 비전 모델을 개발할 수 있도록 한 것입니다.

AIY 비전 킷을 활용할 수 있는 첫 번째 프로그램은 사람과 개, 고양이를 구별하는 것입니다. 그 밖에 1,000가지가 넘는 사물을 인식하는 프로그램도 있으며, 개발자는 AIY 비전 킷을 이용하여 여러 가지를 시각적으로 인식하는 AI를 직접 개발할 수 있습니다. 이제 무언가를 식별하도록 가르쳐야 하는 AI에 더 쉽게 접근할 수 있게 될 것이며, 생태계가 확장할수록 고도화된 컴퓨터 비전이 지금보다 보편적인 기술로 활용되리라 예상할 수 있습니다.

컴퓨터 비전이 발전한다는 건 컴퓨터가 볼 수 있는 것이 늘면서 자동화나 기계화를 이루는 데에 성과를 낼 것으로 여길 수 있습니다. 실질적으로는 컴퓨터 인터페이스에 큰 변화가 생기는 거죠. 지금까지 컴퓨터 인터페이스는 모니터에 가장 오랜 시간 갇혀 있었습니다. 컴퓨터의 눈이 현실의 더 많은 것들을 본다면 모니터 속의 한계를 넘어 현실에 간섭할 여지가 생긴다는 걸 의미하죠. 당연히 현실에 가상 물체를 겹쳐 보여주는 AR은 새로운 컴퓨터 인터페이스의 근간이 될 가능성이 큽니다. 두 분야는 함께 성장할 것입니다.

글로벌 시장조사기관인 트랙티카(Tractica)는 컴퓨터 비전 분야가 2022년까지 486억 달러 규모로 매년 42%씩 성장할 것으로 전망했습니다만, 기술의 발전뿐만 아니라 앱 생태계처럼 컴퓨터 비전으로 생태계를 구성하려는 시도가 성장 속도가 더 빨라질 수 있다고 봅니다. 사람의 눈보다 컴퓨터의 눈으로 보는 것들이 훨씬 많아지겠죠. 보편화할 컴퓨터 비전과 변화할 컴퓨터 인터페이스에 대해 어느 때보다 선도적인 고민을 할 시점입니다.