칩 전쟁으로 번지는 AI 전쟁

AI 전쟁이 AI 칩 전쟁으로 번지고 있습니다.

AI 모델을 구축하는 데는 데이터 학습(Traning)이, 모델이 그림과 이미지, 동영상을 생성하는 데는 추론(Inference)이 필요합니다. 이 과정에서 반도체가 핵심입니다. 칩 값이 비싸면 AI 서비스 인프라 비용이 올라가기 때문에 많은 AI 기업이 직접 칩을 설계해 비용을 절감하려 애쓰고 있습니다.

최근 오픈AI의 9,000조 원에 달하는 칩 투자 자금 유치 소식은 전 세계에 큰 화제를 불러일으켰습니다. 오픈AI CEO 샘 올트먼은 2024년 1월, 한국을 방문해 반도체 업계 대표를 만났고, 대만의 TSMC, 미국의 인텔 CEO와도 면담했습니다. 아랍에미리트(UAE)에 방문했을 땐 아랍에미리트 대통령의 친동생인 셰이크 타흐눈 빈 자이드 국가안보보좌관을 만나기도 했습니다. 월스트리트저널은 이에 대해 “샘 올트먼 CEO가 5조~7조 달러(약 6,600조~9,300조 원)에 달하는 투자 자금 유치를 목표로 뛰어다니고 있다”고 보도했습니다. 해당 금액은 시가총액만 놓고 보면 24년 2월 22일 기준으로 엔비디아 2,619조 원, TSMC 897조 원, 삼성전자 435조 원 인텔 242조 원, 퀼컴 230조 원 등 상위 20개 반도체 기업을 모두 사들이고도 남는 금액입니다. 샘 올트먼은 이후 “9,000조원은 생태계 전체에 걸친 투자금액”이라며 한발 물러섰지만, AI 반도체에 대한 관심은 크게 고조된 상태입니다.

AI 서비스 품질을 높이는 AI 칩

오픈AI의 사례처럼, AI 기업들이 AI 반도체 개발을 서두르는 이유는 크게 5가지가 있습니다.

• 속도 향상: 효율적인 AI 칩은 데이터 처리와 연산 속도를 더 빠르게 합니다. 사용자가 AI 기반 서비스를 이용할 때 지연 시간이 줄어들고, 더욱 신속한 응답을 받게 되는 것인데요. 실시간 번역, 음성 인식, 영상 처리 등의 서비스를 훨씬 더 빠르고 부드럽게 운영할 수 있습니다.

• 에너지 효율성 증가: 적은 에너지로 더 많은 작업을 수행할 수 있습니다. AI칩을 활용하면 데이터센터의 에너지 소비를 줄이고, 스마트폰, 태블릿, 노트북과 같은 휴대용 장치에선 사용 가능 시간을 연장할 수 있습니다.

• 서비스 범위 확장: AI 기술을 적용할 수 있는 분야가 확대됩니다. IoT(사물인터넷) 장치, 스마트 홈 기기, 자율 주행 차량 등에 AI 기능을 통합하는 것이 더 쉬워집니다.

• 정확도 및 신뢰성 향상: 효율적인 연산을 통해 AI 모델이 더 복잡하고 정교한 학습을 수행할 수 있게 합니다. 이를 통해 인식률, 예측 정확도 등 AI 서비스의 전반적인 품질을 높일 수 있습니다.

• 개인화된 서비스 제공: AI 칩은 더 많은 데이터를 실시간으로 처리할 수 있게 하는데요. 서비스사용자의 실시간 데이터 처리량을 늘려 맞춤형 서비스의 개인화 수준을 높일 수 있습니다. 개인의 취향과 행동 패턴을 토대로 맞춤형 추천 시스템을 만들 수 있습니다.

챗GPT 속도가 13배 빨라지는 LPU의 등장

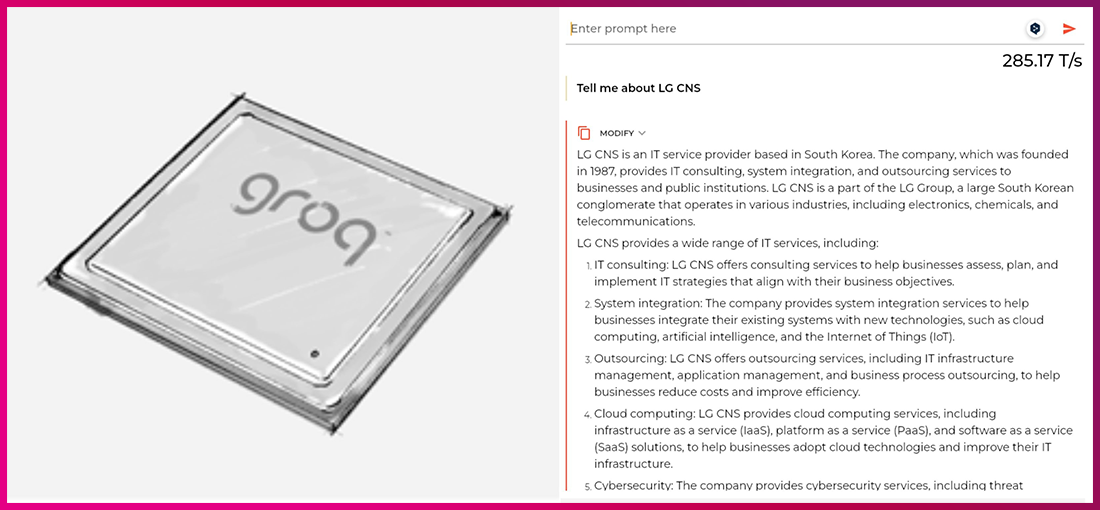

그중 대표적인 기업이 그로크(Groq, 이하 그로크)입니다. 그로크는 구글 칩 엔지니어 출신인 조나단 로스(Jonathan Ross) 등이 설립한 칩 설계 기업으로, 2024년 2월에 대규모 언어 모델(LLM) 전용 칩을 발표한 바 있습니다. 해당 칩이 화제가 되면서 엔비디아 주가가 실적 발표를 앞두고 4.35% 하락했는데요. 그만큼 그로크 칩이 파괴적이라는 반증이기도 합니다. 그로크가 내놓은 AI 칩은 LLM에 특화된 LPU(Language Process Unit, LLM 추론 연산에 최적화된 가속 반도체)입니다. 이 칩에는 5,120개의 벡터 산술 논리 장치(ALU, Arithmetic and Logical Unit, 산술연산과 논리연산을 계산하는 디지털 회로)가 있고, 320×320 크기의 행렬 곱셈을 통해 매우 빠른 연산 속도를 낼 수 있습니다. 또한, INT8(8비트 정수 연산, 컴퓨터 메모리에 저장되는 데이터의 양을 줄이는 데 사용) 연산에서 750TOPS(1초당 750조 번의 AI 연산, TOPS는 1초당 1조번의 AI 연산을 뜻함)를 처리할 수 있습니다. 그로크 칩은 TSP(Tensor-Streaming Processor) 라는 특별한 구조를 기반으로 한 싱글 코어 장치입니다. TSP는 그로크가 개발한 아키텍처로 작업량에 따라 처리 속도가 달라지던 기존 GPU와 달리 응답 시간 및 처리 속도를 일정하게 유지할 수 있는 구조를 뜻합니다.

빅테크 기업의 칩과 비교해 보면, 엔비디아의 최신 H100칩은 INT8 연산에서 1000TOPS, 애플의 M1 울트라 칩은 215TOPS가 가능하지만, 이 칩들은 멀티 코어로, 싱글 코어 구성의 그로크 칩에 비해 에너지 소모가 더 큽니다.

또한 대규모 언어 모델(LLM)에 특화된 그로크의 LPU는 벤치마크 테스트에서 8개 경쟁 기업의 클라우드 기반 추론 성능을 앞질러 업계를 놀라게 하기도 했습니다. MS 애저 클라우드가 초당 19개 토큰을 생성할 때, 그로크의 LPU를 장착한 메타의 LLM ‘라마 2’는 초당 285개 토큰을 생성했습니다. 100개 토큰을 생성하는데 그로크는 0.8초, MS는 10.1초가 소요된 것입니다. 즉, 챗GPT를 그로크 LPU 기반으로 구동한다면 응답속도는 13배 이상 빨라질 수 있습니다.

그로크는 한 가지 사례일 뿐, 오늘날 다양한 빅테크 기업이 AI 칩 개발에 사활을 걸고 있습니다.

• 구글 텐서프로세싱유닛(TPU): 기계 학습 작업을 위해 특별히 설계된 ASIC(Application- Specific Integrated Circuit)입니다. 고성능 기계 학습 모델을 효율적으로 실행하기 위해 최적화한 것이 특징입니다.

• 애플 뉴럴엔진(Neural Engine): 아이폰과 아이패드에서 구동되는 엔진입니다. 애플의 A시리즈 칩에 탑재돼 있는 AI 프로세서로 사진 인식, 언어 처리 등이 최적화 돼있습니다.

• AWS 인퍼런시아: 클라우드 기반 AI 추론 작업을 위해 설계된 칩으로 높은 처리량과 낮은 지연 시간이 장점이며, 비용대비 성능 면에서 우수합니다.

• 화웨이 어센드 AI 프로세서: 모바일 기기와 클라우드 서버에서 AI 연산을 위해 개발된 칩이며,넓은 범위의 AI 응용 프로그램을 지원합니다.

• 테슬라 도조·D1: D1칩을 기반으로 한 도조는 자율 주행 차량의 AI 모델을 학습시키기 위해 개발 중인 AI 트레이닝 슈퍼컴퓨터입니다.

AI 칩 개발 투자에 뛰어든 LG

LG그룹 역시 AI칩 개발과 투자에 적극 가세하고 있습니다. LG전자는 2023년 5월 중앙처리장치(CPU)의 거장으로 불리는 짐 켈러(텐스토렌트 CEO)와 함께 스마트 TV, 전장, 데이터센터에 들어가는 AI 칩 개발 사업에 뛰어들었습니다. 짐 켈러는 “LG전자와 이번 협력을 통해 미래 칩 솔루션을 위한 기술 포트폴리오를 강화할 것”이라며 “제품을 차별화할 수 있는 더 큰 유연성을 확보하게 될 것”이라고 강조했습니다. LG AI 연구원 역시 국내 AI 칩 스타트업 퓨리오사AI와 함께 칩을 개발하기로 했습니다. 퓨리오사AI의 목표는 2세대 칩인 레니게이드를 올 2분기에 공개하는 것입니다. LG AI 연구원은 퓨리오사AI 레니게이드를 활용해 AI 기술 검증을 하고 초거대 AI인 엑사원 기반의 생성형 AI 상용화를 주도할 방침입니다. 퓨리오사AI가 초거대 AI 모델의 안정적인 구동을 위한 칩을 맡은 것입니다.

AI 칩으로 바라본 AI 서비스의 미래

클라우드 기업은 고객의 다양한 수요를 충족시기키 위해 멀티 칩 전략을 활용하고 있습니다. 다양한 AI 칩을 인프라 구축 단계에 장착해, 고객에게 더 넓은 가격 범위를 제공하는 것인데요. 클라우드 서비스는 크게 인프라, 머신러닝(ML), 애플리케이션 등 3계층(Layer)으로 구성돼 있습니다. 프라사드 칼야나라만 AWS 인프라 서비스 부사장은 다양한 칩을 인프라 단계에서 개발하고 설치하는 이유에 대해 “고객의 요구사항은 매우 다양하다”며 “일부 고객은 LLM 서비스만을 사용하려 하고, 일부 고객은 자체 LLM을 구축하려 한다”고 말했습니다. 이어 그는 “결국 고객 입장에선 자신에게 맞는 서비스를 더 낮은 가격에 이용하는 것이 중요하다”고 설명했습니다.

AI 서비스는 클라우드, AI 칩과 궤를 같이하고 있습니다. AI 서비스 전쟁이 AI 칩 전쟁으로 번지는 현상은 숫자로도 뒷받침되는데요. 글로벌 시장조사기업 브레이니인사이트에 따르면 전 세계 AI 칩 시장은 2022년 기준 149억 달러(19조 8,542억 원)로 평가받고 있으며, 2032년까지 3,837억 달러(511조 2,902억 원) 규모로 성장할 것으로 전망되고 있습니다. 이는 AI 기술 발전과 적용 범위 확대에 따른 것인데요. 모도인텔리전스는 2024년 클라우드 컴퓨팅 시장 규모를 6,800억 달러(906조 1,000억 원)에 달할 것으로 추산했으며, 2029년까지 1조 4,400억 달러(1,918조 8,000억 원)로 성장할 것이라 예측했습니다. AI 칩과 클라우드가 AlssA(Artificial Intelligence as a Service, 서비스형 AI, AI 기술을 클라우드로 구현하여 제공하는 서비스) 시장을 끌어올리고 있습니다. AlssA는 2022년 77억 9,000만 달러(10조 3801억 원)에서 매년 37.4%씩 성장한다는 것이 그랜드뷰리서치의 설명입니다.

글 ㅣ 이상덕 ㅣ 매일경제 기자·미라클AI 에디터·<챗GPT 전쟁: 실리콘밸리는 지금 무엇을 준비하고 있는가> 저자