인공지능은 많은 산업의 흐름을 바꿉니다. 음악 산업 역시 인공지능으로 인해 크게 변화했으며, 앞으로 더욱 큰 변화가 일어날 산업입니다. 전통적인 음반 소비가 온라인 스트리밍으로 옮겨가고, 공연장에서 열리던 콘서트는 온라인 콘서트로 대체되고 있습니다. 과거에는 음악을 데이터로 인식하기 어려웠지만, 이제는 단순히 듣고 즐기는 대중문화 콘텐츠가 아닌 하나의 데이터로 인식되면서 이러한 변화는 더욱 가속화되고 있습니다.

최근 인공지능은 미술, 음악, 소설과 같은 예술 영역에 도전하고 있습니다. 수많은 그림을 학습해 인공지능이 그림을 그리기 시작했습니다. 피카소가 그린 느낌의 그림을 인공지능이 그려내고, 많은 책을 학습해 운율이 살아 있는 시를 짓기 시작했습니다. 이제 인공지능은 대량의 음악 데이터를 학습합니다. 피아노를 배우지 않아도 인공지능은 음악을 작곡하고, 청취자의 취향을 분석해 좋아할 음악을 골라냅니다.

현재 음악 산업에서 가장 활발히 활용되는 인공지능은 작곡 분야와 음악 추천이 대표적입니다. 인공지능은 과연 어떻게 음악을 공부하고 음악을 만들 수 있는지, 음악 추천은 어떻게 할 수 있는지 알아보겠습니다.

음악과 기술의 만남

음악을 기술과 학문을 통해 만들려는 노력은 1950년대부터 시작됐습니다. 당시에는 통계 모델을 활용해 음악을 작곡하려는 시도가 있었습니다. 전통적인 악기로 만드는 음악은 1960년대 큰 변화를 맞습니다. 1960년대 탄생한 전자악기는 컴퓨터로 음악을 만들고 처리할 수 있는 계기가 됐습니다.

1970년대부터는 다양한 전자 장비, 악기가 등장하고 동시에 음악을 컴퓨터 소프트웨어로 작곡하기 시작했습니다. 1990년대 이르러서는 음악 생성 프로그램이 개발되고 당시 이 프로그램을 이용한 몇몇 앨범이 발매되기도 했습니다.

음악은 오랫동안 인간의 전유물로 여겨져 왔습니다. 그러나 인공지능이 1차, 2차 성장 붐을 겪으면서 인공지능을 음악에 적용하려는 움직임이 더욱 가속화됐습니다. 인공지능이 본격적으로 활용되면서 구글을 비롯한 IT 기업, 대학 등에서 음악과 관련한 인공지능 알고리즘을 개발하기 시작했습니다. 여기서 가장 큰 변화를 끌어낸 인공지능의 분야가 바로 딥러닝(Deep Learning)입니다.

음악에는 음악이 지닌 고유의 특징이 있습니다. 소리의 높낮이나 빠르기 등 다양한 특징이 있고, 연주곡이 아닌 가사가 포함된 음악에는 가사, 즉 텍스트가 고유의 특징이 됩니다. 음악이 지닌 특징을 처리하고 전체적인 가사의 맥락까지 이해하기 위해서는 과거의 단순한 통계와 프로그래밍 수준으로는 불가능합니다.

딥러닝은 기본적으로 인공신경망(ANN, Artificial Neural Network)을 기초로 합니다. 인공신경망은 사람의 신경망 구조를 모방해 만든 알고리즘인데 단점이 있습니다. 복잡하게 구성할수록 컴퓨터가 계산해야 할 연산량이 급격히 늘어나고 이에 따라 학습 시간이 길어집니다. 시간이 오래 걸리고 부하가 발생하니 이를 처리하는 하드웨어에도 많은 부담이 발생합니다.

음악과 순환 신경망(RNN)

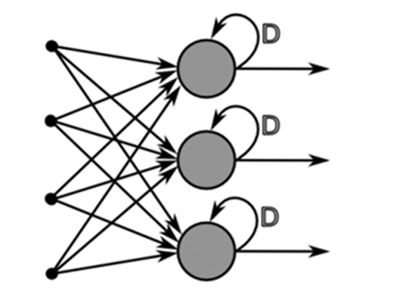

그래서 음악 생성을 위해 딥러닝의 한 종류인 순환 신경망(RNN, Recurrent Neural Network)을 사용합니다. 순환 신경망은 딥러닝에 있어 가장 기본적인 시퀀스(Sequence) 모델입니다. 시퀀스는 연속된 순서가 있는 입력을 의미하는데, 음악에는 연속된 음계, 가사가 포함되어 있습니다.

그런데 음악에는 길이가 정해져 있지 않습니다. 어떤 음악은 3분, 어떤 음악은 10분이 넘는 경우가 있습니다. 기존 인공신경망 모델은 가변적인 시퀀스에는 적합하지 않습니다. 순환 신경망은 이러한 시퀀스 데이터를 학습하기 위해 등장했습니다.

순환 신경망은 인공 신경망의 특정 부분이 반복되는 구조로 되어 있습니다. 과거의 데이터로 돌아갈 수 있는 통로를 가지고 있고 과거의 데이터가 미래에 영향을 줍니다. 순환 신경망 내 구조는 마치 쇠사슬처럼 연결되어 연속된 데이터를 학습하고 반복하고 과거의 데이터를 기억한 뒤 반영하기 적합하도록 만들어져 있습니다.

순환 신경망은 마치 ‘기억력’과도 같습니다. 글을 읽을 때 지금 단어뿐만 아니라 앞서 읽었던 단어와 앞으로 나올 단어를 함께 생각할 수 있는데, 앞선 내용으로 현재 내용을 이해하듯이 순차적인 데이터를 연결해 정보를 파악하고 학습할 수 있습니다. 따라서 음악과 같은 연속된 데이터의 구조에 적합하며 음악뿐만 아니라 음성인식, 번역 등에도 활용되고 있습니다.

하지만, 순환 신경망은 데이터의 거리가 멀어질수록 데이터를 연결하는 능력이 없어집니다. 컴퓨터도 기억하려면 많은 메모리, 컴퓨팅 파워가 필요합니다. 앞에서 읽은 데이터를 뒤에서 기억할 수 없는 경우가 생깁니다.

이 문제를 해결하기 위해 LSTM(Long Short-Term Memory)이라는 딥러닝 프레임워크가 고안되었습니다. 꼭 필요한 정보를 잊어버릴지 보존할지, 중요한지 등을 결정하고 저장해 활용합니다. LSTM은 음악 생성, 작곡처럼 오랜 시간 정보를 기억해야 하는 문제를 해결하는 데 사용됩니다.

계속 발전하는 음악 인공지능

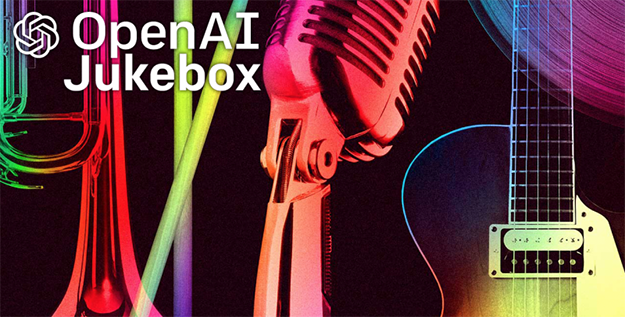

이러한 딥러닝 방식을 가장 잘 활용한 대표적인 음악 인공지능이 오픈에이아이(OpenAI)의 뮤즈넷(MuseNet)과 주크박스(Jukebox)입니다. OpenAI는 2015년 테슬라 창업자 일론 머스크, 전 Y컴비네이터 회장 샘 알트맨 등이 설립한 인공지능 연구기관입니다. 마이크로소프트가 10억 달러를 투자했을 정도로 OpenAI는 인공지능 개발의 중심에 있습니다.

OpenAI는 2019년 뮤즈넷을 공개했는데, 10개 악기를 사용해 음악을 만들어 냅니다. OpenAI는 어텐션(Attention) 기법을 활용한 트랜스포머(Transformer) 모델을 사용했습니다. 어텐션은 중요한 정보 위주로 기억하는 개념입니다. 데이터 간 유사성을 파악하고 중요한 정보인지 확인하고 이를 활용합니다. 이는 순환 신경망에서 컴퓨터가 할 일을 크게 줄여줍니다.

OpenAI는 이러한 모델을 활용해 음을 몇 개 입력하면 알아서 다음 음을 만들어내는 음악 인공지능을 만들었습니다. 뮤즈넷은 음악 산업에서 가장 대표적으로 사용되는 미디(MIDI, Musical Instrument Digital Interface) 데이터를 기반으로 음악을 생성했습니다. 미디는 컴퓨터가 활용하기 용이한 형태로 데이터가 저장되어 있습니다.

OpenAI가 올해 5월 공개한 주크박스는 오디오 사운드 자체를 활용합니다. 오디오 사운드는 파형을 지니고 있는데 이 파형을 인코더를 통해 코드로 만들고 트랜스포머에 입력해 음악을 생성합니다. 그리고 디코더를 사용해 다시 오디오 사운드로 변환합니다.

이러한 과정에서 어텐션 기법이 사용되지 않는 생성적 대립 신경망(GAN, Generative Adversarial Network)과 변이형 오토 인코더(VAE, Variational Autoencoders) 등을 활용해 노래나 가수의 목소리를 다양하게 변형할 수 있습니다. OpenAI의 연구 개발 사례를 보면 각 인공지능 알고리즘마다 차이가 있지만, 순환 신경망과 GAN 등 여러 인공지능 기술이 음악 생성에 활용되고 있음을 알 수 있습니다.

아마존은 딥컴포저(Amazon DeepComposer)라는 인공지능 음악 생성 프로그램을 공개했습니다. 아마존은 GAN을 활용해 생성자와 식별자가 지속해서 데이터를 주고받으면서 목표한 음악을 만들어 내는 데 중점을 두고 있습니다.

물론 OpenAI의 주크박스나 아마존의 딥컴포저 등이 만들어낸 음악은 아직 인간이 만든 음악과는 구분이 되는 편이고 음악이 기존 음악보다 뛰어나다고 볼 수는 없습니다. 하지만, 시간이 지나면서 점차 많은 음악 관련 데이터를 학습하고 컴퓨팅과 하드웨어의 발전 등이 동반되면 인공지능이 어떠한 음악을 만들어 낼 수 있을지 가늠하기 어렵습니다.

최고의 음악을 고르는 인공지능

음악을 만드는 것보다 가장 우리에게 친숙하게 활용되는 인공지능은 음악 추천 분야입니다. 전 세계 대부분의 음악 스트리밍 서비스는 인공지능 기반 음악 추천을 내세우고 있으며, 사용자 개인 데이터를 기반으로 개인화 추천이 가능하다고 이야기합니다. 사용자 개인의 음악 감상 이력과 비슷한 사용자의 음악 재생 이력, 음원 간 유사성을 분석하는 기술 등을 통해 인공지능 기반 추천이 가능합니다.

거의 모든 음악 추천은 협업 필터링(Collaborative Filtering)과 콘텐츠 기반 필터링(Content Based Filtering) 알고리즘을 주로 사용합니다. 협업 필터링은 인공지능이 사용자에게 음악을 추천할 때, 다른 사용자의 정보를 활용해 사용자가 듣지 않았던 음악을 추천합니다. 다른 사람이 들은 음악을 바탕으로 비슷한 음악을 알아내 추천하는 방식입니다.

다만 이러한 방식은 다양한 장르의 선곡이 어려워 비슷한 음악 장르만 추천하거나 특정 취향으로 쏠릴 수 있는 단점이 존재합니다. 이러한 단점을 보완하기 위해 인기차트만 듣는 사용자의 이력은 학습에서 제외하거나, 인기곡 편중 이슈를 보정하기 위한 학습 데이터를 별도로 생성해 입력 데이터로 활용하는 방법도 있습니다.

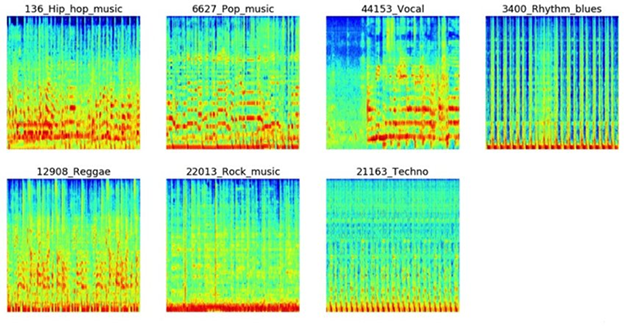

콘텐츠 기반 필터링의 경우 음악 자체의 특성을 기반으로 추천하는 방법입니다. 음악 자체 정보를 추출하기 위해 딥러닝이 활용됩니다. 음악 신호를 ‘그림’ 형태로 변환하는 과정이 먼저 진행됩니다. 그림으로 만든 음원 신호를 분석해 음악 간 유사도나 특성을 파악해 비슷한 음악을 추천합니다. 인기 차트만 듣는 사용자들의 청취 이력은 제외하고 AI 딥 러닝을 통해 추천의 정확도를 높입니다.

이러한 알고리즘을 통한 추천과 더불어 인공지능은 음악의 장르와 무드, 가수 별 특성, 사용자가 음악에 남긴 해시태그 등의 데이터를 토대로 음악을 분류하고 학습합니다. 음악 자체의 오디오 특성과 더불어 다른 음악과의 유사도, 해시태그 유사도, 사용자의 청취 행동 유사도 등 다양한 데이터와 특징이 음악 추천에 활용되고, 이 과정에 인공지능을 활용합니다.

음성 합성으로 완성될 음악 인공지능

과연 인공지능은 음악을 이해하고 음악을 만드는 인간의 감성과 특성을 그대로 따라 할 수 있을까요? 인공지능이 만든 음악이 음악 차트 1위를 차지하고 더는 작곡가나 음반 제작사가 존재하지 않는 시대가 찾아올 가능성을 이제는 배제할 수 없을 것으로 보입니다.

일부 사람들은 인공지능이 인간의 감정과 창작성을 배제하고 음악을 만들고 추천하기 때문에 음악 산업에 부정적인 영향을 줄 수 있다고 걱정합니다. 또한, 인공지능이 만든 음악이 인간의 만든 음악 수준과 비슷하거나 이를 넘어서면 인간 창작자가 설자리가 없어질 것이라고 우려하기도 합니다.

하지만, 인공지능은 엔터테인먼트 기획사나 음반 제작 레이블이 하는 일을 대체할 수는 없습니다. 음악 산업에서 인간만이 할 수 있는 영역이 존재합니다. 인공지능은 인간의 영역을 침범하는 것보다 음악 작업을 더욱 효율적으로 할 수 있도록 인간을 돕는 역할이 핵심입니다. 이미 인공지능은 각종 전자 장비와 프로그램에서 생성된 데이터로 창작자의 수고를 크게 덜어주고 있습니다.

인간은 인공지능을 활용해 음악을 만들고 음악 관련 데이터를 분석해 대중이 원하는 음악과 트렌드를 빠르게 찾을 수 있습니다. 창작자는 음악을 만드는 과정에서 인공지능의 도움으로 새로운 창작 아이디어를 얻을 수도 있습니다. 심지어 인공지능과 함께 작업해 음악을 만들 수도 있습니다.

사실 인공지능이 음악 산업에 불러온 가장 큰 변화는 작곡가, 연주가, 가수 등으로 이루어진 산업 구조의 장벽을 허물어 버렸다는 점에 있습니다. 인공지능의 발전은 음악의 대중화와 더 많은 사람의 폭넓은 참여를 끌어내는 계기가 됐습니다. 이제는 음악 전문가가 아니어도 누구나 인공지능을 활용해 음악을 만들어낼 수 있습니다. 앞으로 인공지능이 음악 산업에서 만들어갈 많은 변화가 기대됩니다.

글 l 윤준탁 l IT 저널리스트