“뉴스 서비스의 발전을 위해 빅데이터는 어떻게 활용될까요?”

뉴스의 진보를 위해 빅데이터가 어떻게 서비스에 활용될 수 있는지 하나하나 짚어보도록 하겠습니다.

수많은 뉴스를 수집하고 체계적으로 분류하기

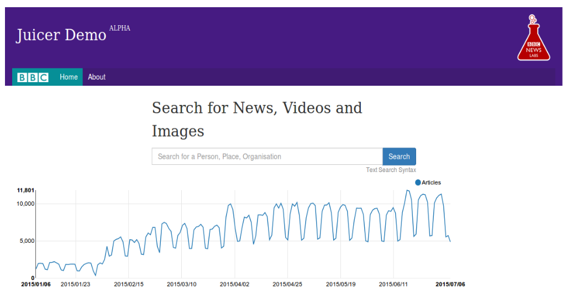

‘Juicer’

과일이나 야채의 즙을 짜내는 기구를 말하려는 게 아닙니다. 영국의 공영방송 BBC에서 뉴스를 집계하거나 뉴스 콘텐츠를 추출해내는 API를 말하려는 겁니다. 그 API를 Juicer라고 부르거든요. BBC는 Juicer에 대해, ‘뉴스를 수집하고 집계하는 파이프라인(Pipeline)’으로 소개합니다.

현재 BBC Juicer는 영국 국내뿐만 아니라 전 세계의 뉴스 방송사에서 제공하는 약 850개의 RSS 피드를 모니터링하여 뉴스를 수집하죠. 그야말로 대용량의 뉴스 빅데이터가 수집되고 체계적으로 분류되는 것입니다.

무료로 제공되는 뉴스 콘텐츠라면 이 Juicer에 의해 모두 포착된다고 합니다. 또한 수집된 뉴스들이 알고리즘을 통해 사람, 장소, 조직 등과 같은 정보들을 기준으로 개념화되어 분류된다고 하는데요. 뉴스에 이러한 정보들이 포함되면 알아서 알고리즘이 이를 걸러내 구분해준다는 것이죠.

그럼 이렇게 정보들을 개념화하고 분류하는데 필요한 데이터는 어떻게 업데이트 될까요? 위키피디아와 연동을 통해서 가능하다고 합니다. 수많은 메타데이터를 모아 정보를 확인하고 정보의 내용을 알아내는데, 그 정보들은 계속 최신 위키피디아 데이터를 기반으로 업데이트 된다고 하니 언제든 정확하고 신속하게 뉴스 정보를 수집하고 분류할 수 있게 되는 겁니다.

BBC가 Juicer를 통해 준비하고자 하는 바는 명확합니다. 바로 로봇 저널리즘(Robot Journalism), 혹은 자동화 저널리즘(Automated Journalism)이라고 불릴 새로운 뉴스 환경에 대비하고자 하는 것입니다. BBC는 이미 2012년부터 Juicer를 사용해 뉴스를 생산했다고 하죠. 그러니 언젠가 이 Juicer가 더 업그레이드되면, 기자나 독자 등의 이용자들이 Juicer를 통해 자신이 원하는 뉴스를 한치의 오차도 없이 찾아 이용할 수 있게 되겠죠.

뉴스를 매개로 사람들과 소통하기

그런데 뉴스 빅데이터를 수집하고 집계하는 프로그램만 발달된다고 해서 그 자체로 로봇 저널리즘이나 자동화된 뉴스 제공 환경을 구현할 수 있는 것은 아닙니다. 많은 미디어 회사들이 챗봇(Chatbot)을 만들어 뉴스를 매개로 사람들과 소통하는 방식으로 서비스를 제공하죠. 바로 챗봇이 생산되는 단계가 빅데이터를 통해 뉴스 서비스가 더욱 자동화 되는 다음 단계라고 할 수 있습니다.

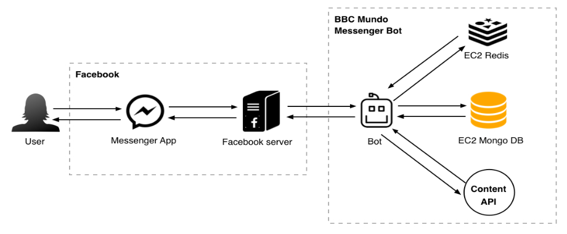

BBC는 기사 내에서 챗봇을 통해 사람들이 궁금해하는 점을 대화로 알려주기도 하고, 페이스북 메신저에 퀴즈봇(Quiz Bot)을 만들어 자동화된 메시지로 전달하기도 합니다. 아래는 스페인어로 제공되는 뉴스인 ‘BBC Mundo’의 메신저 봇이 페이스북을 통해 어떻게 작동되는지 그 원리를 설명한 것입니다.

사용자가 모바일이나 웹 메신저를 통해 메시지를 보내면, 이 메시지는 페이스북 내부 API를 통해 BBC 봇에 전달됩니다. 다시 봇은 페이스북이 회신을 위해 제공한 특정 URL로 응답 신호를 보내게 됩니다. 물론 이 과정에서 이용자가 원하는 정보가 제공되려면 빅데이터가 활용되죠.

이러한 과정을 거쳐 뉴스 이용자들은 마치 자신의 물음에 응답하는 듯한 메신저 뉴스를 경험하게 됩니다. 엄밀히 따지면 인공지능이나 진정한 의미의 로봇은 아니지만, 빅데이터를 통해 마치 하나의 인격체가 이용자들에게 뉴스를 선별해 제공하는 것처럼 서비스가 구현되는 것입니다.

(출처: http://bbcnewslabs.co.uk/2016/07/12/bots-in-newslabs)

챗봇은 오늘날 많은 미디어 그룹들이 개발해 서비스하고 있죠. 가디언지(The Guardian)도 이미 2016년에 페이스북에서 챗봇을 선보여 지역별 뉴스 시간대나 뉴스 테마에 따라 특화된 기능을 제공하죠. 쿼츠(Quartz) 역시 이미 봇 스튜디오를 설립해 서비스를 제공하며 향후에는 데이터를 생산하고 뉴스를 만드는 과정에서 기자들을 돕는 뉴스룸 봇(Newsroom Bot)도 고려하고 있죠.

(출처: http://www.niemanlab.org/2017/04/these-are-the-bots-powering-jeff-bezos-washington-post-efforts-to-build-a-modern-digital-newspaper)

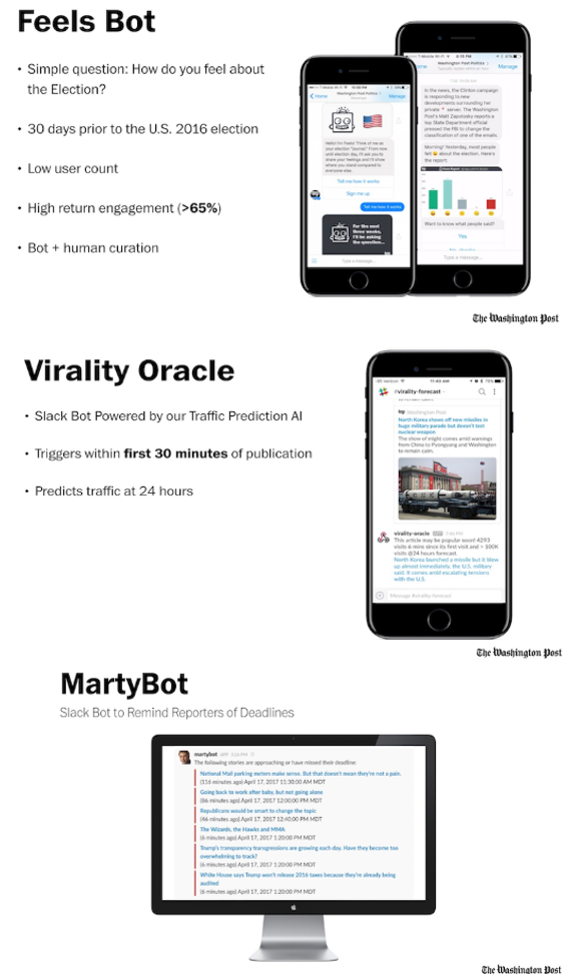

그런데 위 그림들로 나열된 위싱턴 포스트(The Washington Post)의 봇들은 뉴스를 읽는 독자들을 대상으로 하는 것도 있지만 기자들의 뉴스 생산을 돕기 위한 봇도 있습니다.

대중들의 느낌을 표현하는 필스 봇(Feels Bot)은 선거에 관해 어떠한 감정이 주로 확산되는지 보여주는 로봇입니다. 사람들이 선거에 대해 어떻게 느끼고 있는지 직관적으로 보여주어 사람들의 참여를 더욱 늘리는 역할을 하죠. 이용자들이 이 봇을 다시 이용하고 관여한 비율이 65% 이상이라는 것은 그만큼 봇이 직관적이고 쉽게 뉴스를 전달해 확산성을 지니고 있다는 점을 시사합니다.

바이럴리티 오라클(Virality Oracle)이라 불리는 봇은 워싱턴 포스트 내 공공채널에서 활용되는 봇입니다. 뉴스 게시 이후에 첫 30분 동안 작동을 시작해서 24시간의 뉴스 트래픽을 예측할 수 있도록 도와줍니다. 마티봇(MartyBot)은 기자들이 기사를 쓰기 시작하면 이 과정에서 기사 송고 시간을 알려주고 마감 시간 알람을 지속적으로 보내주는 등 일종의 뉴스 생산 과정을 돕는 봇입니다.

경영 전략 수립에 활용하기

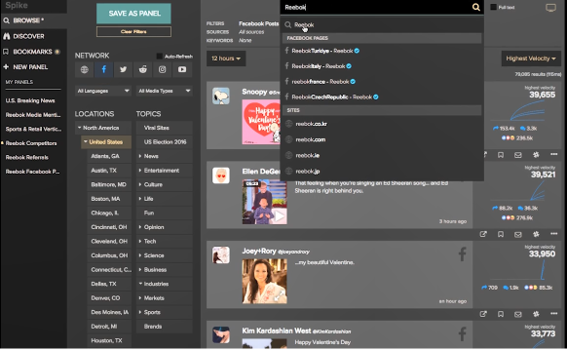

뉴스윕(NewsWhip) 서비스는 전 세계 수십억 명의 사람들이 소셜 네트워크에서 공유하는 이야기를 추적하는 서비스입니다. 서비스는 크게 뉴스윕 스파이크(NewsWhip Spike)와 뉴스윕 애널틱스(NewsWhip Analytics) 두 가지로 나뉘는데, 뉴스윕 스파이크는 빠르게 소셜 콘텐츠를 발견하고 실시간으로 이용자 참여나 현황 등을 예측하는 도구입니다.

반면에 뉴스윕 애널리틱스는 사이트나 플랫폼에서 나타나는 성과를 분석하는 도구죠. 이른바 소셜 네트워크에서 생산된, 또한 텍스트로 구성된 빅데이터를 마이닝해 분석하는 툴에 속하는데요. 최근에는 빅데이터 중에서도 소셜 빅데이터(Social Big Data)라고 구분해 불리는 데이터를 분석하는 것입니다.

이러한 방식으로 빅데이터를 분석하는 시스템은 최근 많이 생겨나고 있지만, 뉴스윕 서비스는 수십억 명의 소셜 사용자들 사이에서 확산되는 어떠한 이야기도 90초 안에 발견할 수 있다는 점을 자랑하고 있습니다. 또한 회사가 밝히고 있는 서비스 기능들을 찬찬히 살펴보면, 기존 언론사들이 경영 전략을 수립하는데 필요한 요소들을 제공하고 있음을 알 수 있습니다.

그럼 뉴스윕 홈페이지에서 뉴스윕 스파이크 기능이 어떻게 소개되고 있는지 살펴보겠습니다.

우선 현재 가장 빠르게 퍼져나가는 이야기를 추적하고 가장 많이 퍼지는 정보를 예측하여 ‘잠재 고객의 공감을 불러 일으키는 콘텐츠를 예측한다.’고 합니다. 또한 키워드, 주제, 위치, 통계 등을 기준으로 손쉽게 정보들을 필터링할 수 있고 이를 한 공간에서 확인하기 쉬워서 ‘현재의 모든 소셜미디어 이용자 참여 현황 살펴볼 수 있다.’고 합니다. 마지막으로 이용자가 특정한 사안에 대해 이야기하는 방식을 다양한 주제의 카테고리로 나눠서 살펴볼 수 있어 ‘잠재 고객이 반응하는 방식을 면밀히 파악할 수 있는 장점도 있다.’고 합니다.

사실 빅데이터를 뉴스 서비스에 활용한다고 하면 뉴스나 정보를 수집해 서비스 자원을 늘리거나 이용자 대상으로 행해지는 자동화 서비스에만 초점을 맞추는 경향이 있는데 최근에는 뉴스윕 서비스처럼 이용자들이 확산시키는 이야기를 보다 면밀히 분석해 잠재적인 뉴스 고객들을 발견하고 그 고객들을 세분화해 분석하는 쪽으로도 서비스가 발전하는 것을 알 수 있습니다.

기존 언론사의 뉴스 유통 체계에서는 상상하기도, 적용하기도 힘든 기술이죠. 이 모든 게 포털과 소셜미디어로 인해 온라인 플랫폼에서의 뉴스 소비가 늘어난 탓이라고 할 수 있으니까요.

(출처: https://www.youtube.com/watch?v=BQGb9c6IX3I)

직접 뉴스를 생산하기

빅데이터로 뉴스 서비스가 발전하는 가장 마지막 단계는 역시, 인공지능이 직접 기사를 생산하는 단계라고 할 수 있습니다. 이 측면에서는 워싱턴 포스트(The Washington Post)의 사례가 자주 인용되죠.

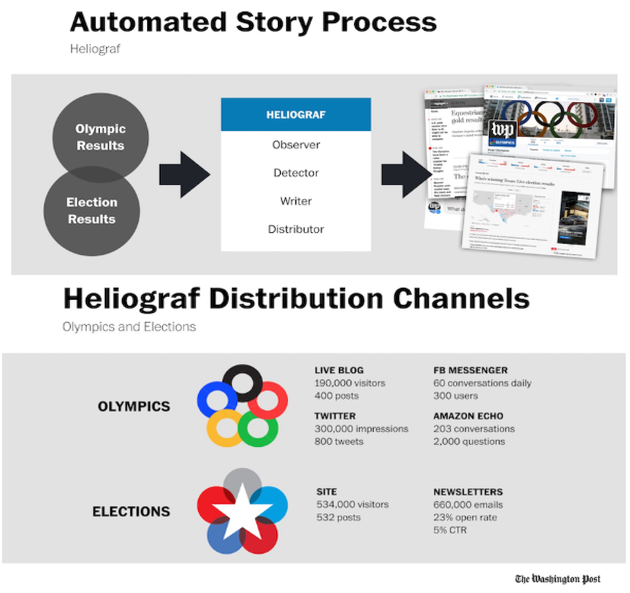

워싱턴 포스트는 자체적으로 헬리오그라프(Heliograf)라는 인공지능 기술을 개발했는데 2016년 개발 첫해에 이미 850건의 기사를 생산했습니다. 여기서 50만 건 이상의 클릭수를 기록한 선거 관련 기사가 500건 포함되어 있었죠. 시장에서 화제를 얻기에 충분했습니다.

워싱턴 포스트는 아마존의 창업자 제프 베조스(Jeffrey Bezos)가 소유하고 있기 때문에 더욱 주목해야 할 필요가 있는데요. 워싱턴 포스트가 과연 아마존의 빅데이터를 기반으로 더 주목할만한 뉴스 서비스를 만들어낼 수 있을지에 대한 부분입니다.

앞서 소개한 워싱턴 포스트의 봇들과 함께 이 헬리오그라프는 보다 진보된 뉴스 서비스를 제공하고 있는 것은 사실입니다. 기존의 빅데이터 분석 체계를 갖춘 회사에서나 제공할 수 있을 법한 서비스를 보여주는데요.

헬리오그라프는 단순히 기사를 생산하는 도구는 아닙니다. 현상을 관찰하고 탐지하며 기사를 작성하고 이를 유통하는 기능까지 수행하고 있죠. 빅데이터를 활용한 뉴스 서비스의 본질적인 기능들을 모두 갖추고 있고 이는 뉴스 서비스가 빅데이터로 지능화되는 일반적인 형태이기도 합니다.

사실 워싱턴 포스트는 헬리오그라프로 기사를 직접 생산하는 인공지능을 갖추고, 봇을 통해서는 뉴스 이용자와 기사를 생산하는 기자들이 모두 만족할 수 있는 접점을 만드는 등 ‘큰 그림의 서비스를 완성해 나가고 있다.’ 할 수 있습니다.

(출처: http://www.niemanlab.org/2017/04/these-are-the-bots-powering-jeff-bezos-washington-post-efforts-to-build-a-modern-digital-newspaper)

많은 우려처럼 정말 직업의 변화가 생길까?

이제껏 언급한, 빅데이터가 활용된 뉴스 서비스를 살펴보면 그 유형이 구분되죠. 뉴스를 수집하는데 빅데이터가 활용될 것인지, 이용자나 생산자들과 소통하는 지점에서 빅데이터가 활용될지, 아니면 경영 전략을 수립하는데, 혹은 직접 뉴스 기사를 생산하게 하는데 빅데이터가 활용될지 크게 네 가지로 구분이 가능합니다.

이 네 가지 구분만 봐도, 사람들의 많은 우려는 불필요한 것으로 보입니다. 즉 빅데이터로 뉴스 생산 체계가 자동화된다고 해서 기사를 생산하는 직업이 쉽게 없어질 것 같지는 않습니다.

아직까지 기사의 중요도를 체크하거나 여론이 생산될 때 함께 확산되는 미묘한(?) 사회적 분위기를 감지하는 어떠한 인공지능과 봇도 생산되지 않았기 때문이죠. 마찬가지로 기사 논조를 자발적으로 결정하거나 탐사보도와 같은 심층적인 기사를 생산하는데 활용할 획기적인 알고리즘의 발전도 아직 갈 길이 멀어 보입니다.

많은 전문가들이 빅데이터로 인한 로봇 저널리즘, 혹은 자동화 저널리즘으로 사람들이 직업을 대거 빼앗길 수 있다고, 초기에는 그러한 예측이 난무했죠. 그러나 오히려 대부분의 기술들이 기사 생산자들을 도울 수 있을 것이라 보는 쪽도 많습니다.

지금까지 개발된 기술들을 보면 빅데이터를 모아서 효율적인 기사 쓰기에 도움을 주는 쪽으로 발전할 가능성이 높다는 것입니다. 물론 반대 의견도 존재하지만 말이죠. 어찌 되었건 간에 빅데이터 수집 및 분석 기술이 진보하면서 인공지능, 봇 등을 잘 다루는 기자가 좋은 기사를 빠르게 생산하는데 더욱 유리할 것이라는 점. 이는 분명해 보입니다.

글 l 최홍규 박사 l EBS 연구위원

저자 최홍규는 학부에서 전자IT미디어공학을 전공하고 이후 미디어학 분야에서 석사와 박사 공부를 마쳤다. 박사 논문은 소셜 빅데이터 마이닝을 통해 사회적 이슈의 확산 양상을 밝히는 연구를 담았다. 다양한 학문 간 융합적 연구에 관심이 많고, 주로 미디어와 커뮤니케이션으로 인한 인간과 사회의 변동을 큰 주제로 삼아 다수의 칼럼과 저서 등을 집필했다. KISA 선임연구원을 거쳐 현재 EBS 연구위원으로 재직 중이며 미디어 콘텐츠, 플랫폼 등의 기획 및 기술 분야 자문역으로도 활동하고 있다.